Le grand défi de la publicité digitale, c’est de diffuser le bon message, au bon moment, auprès du bon public. La publicité doit être également créative et suffisamment pertinente pour capter l’attention.

La publicité programmatique a changé la donne pour le media buying car elle répond à toutes ces problématiques. En automatisant le processus d’achat d’espaces publicitaires, les publicités programmatiques peuvent cibler les consommateurs de manière plus précise, à moindre coût.

La publicité programmatique représente aujourd’hui 72 % de l’ensemble des dépenses publicitaires online. C’est donc le mode d’achat publicitaire le plus utilisé à ce jour par les marques pour développer leur visibilité et leurs ventes.

Vous vous interrogez sur la programmatique : cela va-t-il être rentable, facile d’accès, facile à gérer et à tracker ? Je fais le point dans cet article.

Qu’est ce que la publicité programmatique ?

La publicité programmatique est l’utilisation d’une technologie automatisée pour le processus d’achat d’espace publicitaire, par opposition aux méthodes traditionnelles (souvent manuelles) de publicité digitale (ce bon vieux display à l’ancienne avec l’ordre d’insertion manuel).

L’achat programmatique utilise des données et des algorithmes pour diffuser des publicités au bon utilisateur, au bon moment et au bon prix.

Pour comprendre l’achat programmatique, vous devez connaître la terminologie liée à ce processus. Tout d’abord, l’achat programmatique peut être classé en trois catégories différentes :

L’enchère en temps réel (RTB) : Également connu sous le nom d’enchère ouverte, le RTB consiste à décider des prix de l’inventaire par le biais d’une enchère en temps réel. Comme son nom l’indique, cette procédure est ouverte à tout annonceur ou éditeur. Le RTB est considéré comme un moyen rentable d’acheter des médias avec une grande audience.

Place de marché privée ou Private Marketplace (PMP) : Elles sont similaires aux enchères ouvertes, mais les PMP ont des restrictions sur les personnes qui peuvent y participer. Seuls des annonceurs sélectionnés ont accès aux PMP sur une base d’invitation seulement. Cependant, dans certains cas, les éditeurs peuvent avoir un processus de sélection qui permet aux annonceurs de demander une invitation.

Programmatique directe : il s’agit du cas où un éditeur contourne les enchères et vend l’inventaire média à un coût fixe par mille (CPM) à un ou plusieurs annonceurs.

L’écosystème programmatique comprend également trois composantes principales :

La plateforme de vente (Sell-Side Platform, SSP) : Il s’agit d’un logiciel qui permet aux éditeurs de vendre des impressions publicitaires display, mobiles et vidéo à des acheteurs potentiels, automatiquement et en temps réel. Cela inclut les ad exchanges, les réseaux et les DSP (voir ci-dessous). Cela permet aux éditeurs de mieux contrôler leur inventaire et leurs CPM.

Plate-forme à la demande (DSP) : Il s’agit d’un logiciel qui permet aux agences et aux annonceurs d’acheter de l’inventaire publicitaire sur plusieurs plates-formes.

Ad Exchange : Il s’agit de la façon dont l’offre alimente l’inventaire dans le marché publicitaire. Le DSP se connecte au marché publicitaire, ce qui permet aux annonceurs, aux agences, aux réseaux et aux éditeurs d’acheter et de vendre des espaces publicitaires. Les prix de l’inventaire peuvent ensuite être fixés par le processus d’enchères.

L’inventaire publicitaire est généralement acheté via une enchère en temps réel. En utilisant les canaux programmatiques, les annonceurs peuvent acheter par impression, ciblant ainsi la bonne audience. Le processus étant automatisé, l’achat programmatique de médias garantit une rapidité et une efficacité inégalées par rapport à l’achat traditionnel de médias.

Source photo : moloco.com

Pourquoi l’achat programmatique a-t-il remplacé l’achat publicitaire traditionnel ?

Le processus traditionnel d’achat médias implique beaucoup de taches manuelles, généralement plusieurs propositions (RFP), des négociations humaines et des insertions manuelles (IO), ce qui le rend le processus lent et inefficace. Par ailleurs, les annonceurs ont peu de contrôle sur l’inventaire et le placement.

Quels sont les avantages de la programmatique ?

Que vous soyez une petite ou une grande marque, la publicité programmatique peut offrir de multiples avantages à votre entreprise. En voici quelques-uns :

Capacités de ciblage de l’audience

Pour que vous puissiez tirer le meilleur parti de vos dépenses publicitaires et augmenter votre retour sur investissement, vos publicités doivent toucher les bonnes personnes. Les capacités de ciblage de l’achat programmatique permettent aux entreprises d’afficher des publicités sur les sites éditeurs en fonction de facteurs tels que la localisation, l’intention de l’acheteur, le revenu du ménage, les données démographiques et les intérêts. Cela permet de s’assurer que toutes les publicités sont affichées de manière stratégique aux endroits susceptibles de générer plus de trafic et de revenus.

Automatisation des processus

Avec l’achat média traditionnel, les entreprises doivent passer par le processus laborieux de recherche, de négociation, de demande et de préparation des ordres d’insertion. L’achat de publicité programmatique automatise l’ensemble du processus en permettant aux marques et aux agences d’acheter des espaces publicitaires sur des sites Web et des applications en quelques secondes. Vous gagnez ainsi un temps précieux que vous pouvez mieux consacrer à l’optimisation de votre stratégie de contenu.

Transparence sur l’inventaire acheté

Avant l’invention de la publicité programmatique, les entreprises n’avaient aucun moyen de savoir où leurs publicités seraient affichées précisemment. Cela augmentait leur risque d’exposition à des activités frauduleuses telles que la fraude au clic, la diffusion non contrôlée sur des inventaires non désirés.

Aujourd’hui, grâce à la publicité programmatique, les annonceurs peuvent savoir sur quels sites leurs annonces sont diffusées et qui les consulte.

Une plus grande portée de l’audience

En 2022, d’après Hootsuite, on compte plus de 4,9 milliards d’internautes actifs dans le monde. Cela représente environ 59,5 % de la population mondiale qui pourrait constituer votre public potentiel. La publicité programmatique vous permet d’atteindre ces personnes en vous donnant accès à un inventaire quasi illimité sur des millions de sites Web du monde entier.

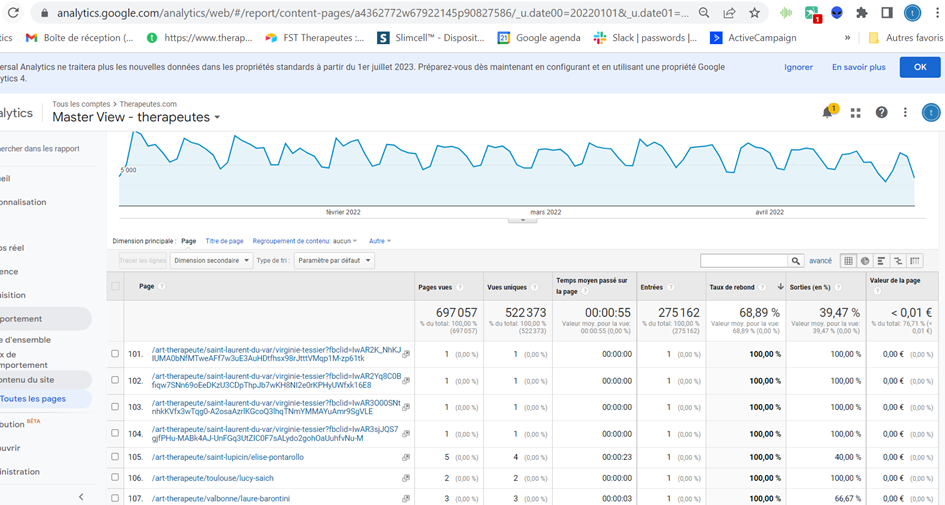

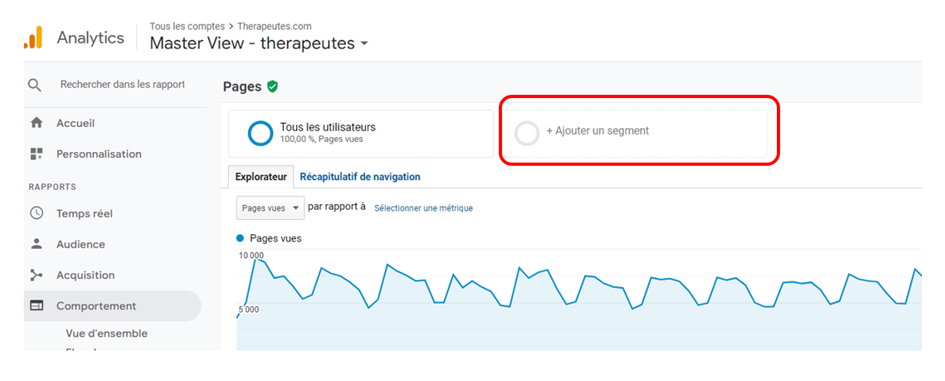

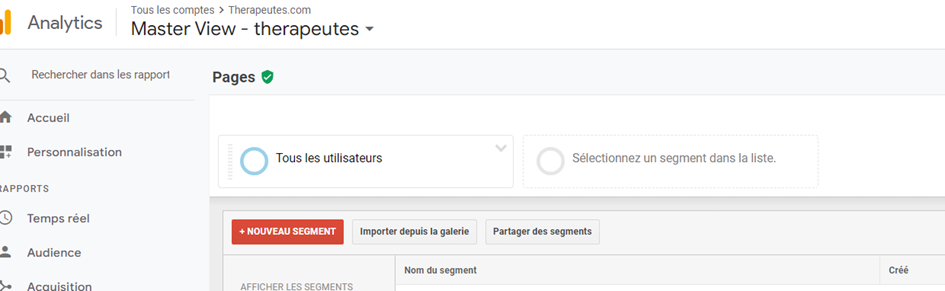

Précision des données et tracking temps réel

La publicité programmatique fournit des statistiques en temps réel sur les performances des campagnes publicitaires. Les entreprises peuvent suivre les performances dès que les publicités ont été affichées sur le site Web. Elles peuvent ainsi déterminer si leur stratégie marketing est efficace ou si elle doit être modifiée.

Voici cinq façons de réussir votre campagne d’achat programmatique

1. Divisez votre public en micro-segments

La microsegmentation consiste à diviser votre public en très petits groupes sur la base de caractéristiques communes. Il peut s’agir de facteurs tels que les données démographiques, les intérêts ou même le comportement antérieur du client.

Voici une analyse de MobileMonkey à ce sujet.

Par exemple, si vous vendez un nouveau type de vélo de course, vous pouvez créer un microsegment pour les personnes qui ont déjà acheté des vélos de course, les personnes qui ont montré un intérêt pour les vélos de course et les personnes qui vivent dans des endroits où le temps est propice à faire du vélo de course.

Avec la microsegmentation, vous ciblez un groupe très spécifique de personnes avec une grande granularité. Cela vous permet de créer des annonces qui sont très pertinentes pour eux, ce qui augmente la probabilité d’obtenir une conversion.

L’inconvénient de la microsegmentation est qu’elle peut prendre beaucoup de temps à mettre en place. Vous devez avoir une idée précise de l’identité de votre public cible et des caractéristiques qu’il partage. Une fois que vous avez défini vos segments, vous devez créer des annonces distinctes pour chacun d’eux.

Des outils tels que Google Ads Customer Match ou Facebook lookalike permettent de cibler facilement les consommateurs qui ressemblent à vos anciens clients. Le ciblage d’audience Google Ads vous permet également de cibler des personnes en fonction de leurs attributs personnels.

2. Laissez les utilisateurs « concevoir » leurs propres produits et diffusez des annonces en fonction de leurs préférences

Une autre façon de cibler les annonces de manière programmatique consiste à laisser les utilisateurs concevoir leurs propres produits, puis à leur proposer des annonces en fonction de leurs préférences. Cette approche est souvent utilisée par les entreprises qui vendent des produits sur mesure, tels que des chaussures ou des bijoux.

Par exemple, imaginez que vous vendez des chaussures sur mesure. Un client se rend sur votre site Web et choisit le style, la couleur et le matériau des chaussures qu’il souhaite. Il sélectionne également la taille et la largeur.

Vous pouvez alors cibler de manière programmatique ce client avec des publicités pour les chaussures qu’il a conçues – et vous pouvez être sûr que ces publicités seront pertinentes pour ce client.

Cette approche est également utile pour les entreprises qui proposent de nombreux produits et doivent cibler leurs clients avec le bon produit au bon moment.

Par exemple, un client peut être intéressé par l’achat d’une nouvelle voiture, mais il ne sera peut-être pas prêt à l’acheter avant plusieurs mois.

Vous pouvez cibler ce client en programmatique avec des publicités pour la voiture spécifique qui l’intéresse et lui fournir des informations sur les options de financement et les offres.

Lorsqu’elle est utilisée correctement, la publicité programmatique peut être un moyen efficace d’atteindre votre public cible avec le bon message au bon moment.

3. Lancez une campagne de retargetting

L’un des moyens les plus efficaces de vendre un produit est de cibler les personnes qui ont déjà montré un intérêt pour ce produit.

Par exemple, si vous savez qu’un client a visité votre site et regardé un produit particulier, vous pouvez le cibler en programmatique avec des publicités pour ce produit.

C’est ce qu’on appelle le retargetting, et c’est un moyen extrêmement efficace de réduire votre CPA et donc augmenter votre ROI.

Les campagnes de retargetting diffusent vos annonces aux personnes qui ont déjà visité votre site Web ou effectué une action spécifique, comme l’ajout d’un article à leur panier, le checkout ou tout simplement la consultation d’une page produit spécifique

Vous pouvez cibler de manière programmatique ces clients avec des publicités pour le produit qui les intéresse et leur proposer une remise avec un code promo par exemple.

Tout ce dont vous avez besoin, c’est d’un pixel sur votre site Web qui aspre les données des clients, puis vous pouvez créer une audience personnalisée dans votre plateforme publicitaire pour les cibler de manière programmatique.

4. Diffusez des annonces en fonction du parcours de vos clients

Comprendre le parcours du client est essentiel à la réussite de la publicité programmatique.

Pour bien faire, vous devez bien comprendre vos clients, ce qu’ils essaient d’atteindre et les étapes qu’ils franchissent pour y parvenir.

Une fois que vous savez cela, vous pouvez tracer le parcours du client et identifier les points de contact clés où les publicités programmatiques seront les plus efficaces.

Par exemple, si vous vendez une nouvelle voiture, le parcours de votre client pourrait ressembler à ceci :

J’ai besoin d’une nouvelle voiture.

Je recherche le type de voiture que je veux.

Je compare différents modèles et marques.

Je décide de la voiture à acheter.

J’achète la voiture.

Comme vous pouvez le constater, il y a plusieurs points de contact dans le parcours du client où les publicités programmatiques pourraient être efficaces, par exemple après qu’il ait recherché le type de voiture qu’il veut ou lorsqu’il compare différents modèles et marques.

Les clients reciblés sont trois fois plus susceptibles de remarquer et de prendre en compte les publicités qui font la promotion de produits qu’ils ont déjà consultés. Si vous pouvez diffuser des publicités programmatiques intelligentes à ces moments clés, vous serez sur la bonne voie pour augmenter les ventes de votre entreprise.

5. Utilisez la vidéo dans vos annonces programmatiques

Utiliser la vidéo dans les annonces est un excellent moyen de se démarquer de la concurrence et de capter l’attention.

C’est aussi un format qui peut générer de meilleurs CTR et améliorer le CPA. Le format vidéo est plus engageant que des publicités statiques ou même des bannières animées. C’est certainement le meilleur format pour attirer l’attention de votre public cible.

L’espace publicitaire peut être acheté de manière programmatique sur plusieurs plates-formes, sous différents formats, comme l’in-stream de YouTube ou les vidéos mid-roll de Facebook.

Lorsque vous combinez la puissance de la vidéo avec la publicité programmatique, vous pouvez créer des publicités très rentables.

Thibaut Fitoussi

Je suis le fondateur de HoD et l'auteur de cet article.

J'espère que vous avez apprécié cet article.

Si vous voulez que mon équipe à HoD vous aide à exploser votre audience et votre ROI, il suffit de nous adresser vos coordonnées.